I Large Language Models (LLM) sono assistenti utili: eccellono nel combinare concetti e sanno leggere, scrivere e programmare per aiutare le persone a risolvere i problemi. Ma potrebbero scoprire conoscenze completamente nuove?

Poiché è stato dimostrato che gli LLM “soffrono” di allucinazioni creando informazioni errate, utilizzarli per fare scoperte verificabilmente corrette è una sfida. Ma cosa accadrebbe se potessimo sfruttare la creatività degli LLM identificando e sviluppando solo le loro idee migliori?

Una nuova ricerca di Google ha fatto proprio questo, ampliando la nostra comprensione di ciò di cui sono capaci i modelli di intelligenza artificiale.

Il paper dal titolo “Mathematical discoveries from program search with large language models”, pubblicato su Nature, esplora l’uso di Large Language Models (LLM) per risolvere complesse sfide matematiche e scientifiche

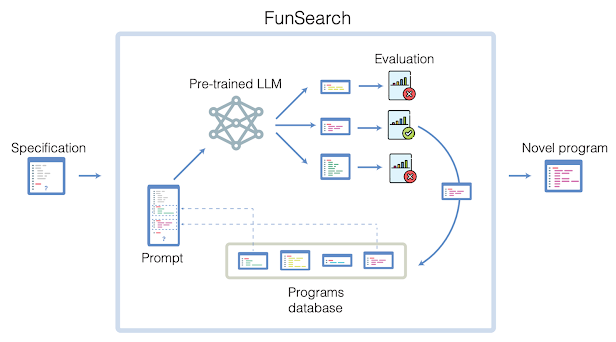

I ricercatori hanno sviluppato un nuovo metodo chiamato FunSearch (ricerca nello spazio delle funzioni) e lo hanno applicato al problema del cap set – un problema di lunga data nella matematica combinatoria estrema – per scoprire nuove soluzioni al problema che vanno “oltre quelle più conosciute, “secondo gli autori.

Questa è la prima volta che un modello di intelligenza artificiale viene utilizzato per scoprire nuove soluzioni a problemi aperti in scienza e matematica, ma gli autori hanno anche dimostrato un’applicazione nel mondo reale di questa scoperta applicandola al problema dell’ “online bin-packing” , che può essere utilizzato per applicazioni come la creazione di data center più efficienti e l’imballaggio dei camion di trasporto in modo più efficiente.

A differenza della maggior parte degli approcci di ricerca informatica, FunSearch cerca programmi che descrivano come risolvere un problema, piuttosto che quale sia la soluzione

Questo studio evidenzia come l’intelligenza artificiale stia emergendo come uno strumento potente non solo per l’elaborazione del linguaggio, ma anche per la scoperta scientifica e la risoluzione di problemi complessi.

Nel 2023, l’intelligenza artificiale ha visto significativi progressi in varie aree, tra cui modelli di linguaggio, elaborazione di immagini, generazione di immagini e video editing. Riassumo qui i più influenti in questi ambiti e i vantaggi che hanno portato o potrebbero portare:

- Sparks of AGI di Microsoft: Analizza una versione iniziale di GPT-4, che rappresenta una nuova classe di modelli di linguaggio di grandi dimensioni con capacità di intelligenza più generalizzata. GPT-4 ha mostrato capacità impressionanti in diversi domini, inclusi matematica, codifica, medicina, legge e psicologia. Questo lavoro suggerisce che GPT-4 potrebbe essere considerato un primo, seppur incompleto, esempio di intelligenza artificiale generale (AGI).

- PALM-Edi Google: Introduce un modello di lingua che incorpora input sensoriali continui, collegando parole e percezioni del mondo reale. Questo modello di linguaggio integra frasi multimodali con informazioni visive, di stima dello stato e testuali, dimostrando notevoli capacità in compiti come la pianificazione della manipolazione robotica sequenziale e il question answering visivo.

- LLaMA 2 di Meta AI: È una versione migliorata del suo predecessore, addestrata su un nuovo mix di dati, che esibisce prestazioni superiori in termini di utilità e sicurezza rispetto ai modelli open-source e comparabili a quelli closed-source. Questo lavoro mira a contribuire allo sviluppo responsabile di modelli di linguaggio di grandi dimensioni (LLM).

- Generative Agents di Stanford University e Google: Presenta agenti generativi in grado di simulare comportamenti umani credibili, con applicazioni in scenari di role-play e prototipazione sociale nei mondi virtuali. Questi agenti possono memorizzare esperienze, sintetizzare ricordi e recuperarli dinamicamente per la pianificazione del comportamento.

- LLaVA by University of Wisconsin–Madison, Microsoft, and Columbia University:

LLaVA (Large Language and Vision Assistant), un modello multimodale all’avanguardia che sfrutta GPT-4, basato solo sul linguaggio, per generare dati che seguono istruzioni sia per testi che per immagini. Questo approccio innovativo estende il concetto di “instruction tuning” allo spazio multimodale, consentendo lo sviluppo di un assistente visivo a uso generale. - Segment Anything di Meta AI: Introduce un modello innovativo per la segmentazione di immagini, creando il più ampio dataset di segmentazione esistente, con oltre 1 miliardo di maschere per 11 milioni di immagini. Il modello SAM (Segment Anything Model) dimostra prestazioni competitive rispetto ai risultati completamente supervisionati su una gamma diversificata di compiti a valle.

- DALL-E 3 di OpenAI: Affronta una delle sfide più significative nei modelli di generazione di immagini da testo: il prompt following. Il documento presenta un sistema di didascalie per immagini specializzato, in grado di generare didascalie altamente descrittive e precise, migliorando significativamente le capacità del modello DALL-E nel seguire i prompt ed essere più preciso nella generazione dell’immagine.

- ControlNetdi Stanford University: Una struttura di rete neurale progettata per controllare modelli di diffusione preaddestrati e supportare condizioni di input aggiuntive. ControlNet apprende condizioni specifiche per il compito in modo end-to-end e dimostra un apprendimento robusto anche con piccoli set di dati di allenamento.

- Gen-1 di Runway: Introduce un avanzamento rivoluzionario nell’editing video attraverso l’unione di modelli di diffusione generativi guidati da testo. Questo modello ha superato sfide significative nell’editing video basato su descrizioni testuali o visive.

- DreamerV3: Un algoritmo innovativo basato su modelli che dimostra prestazioni eccezionali in una vasta gamma di domini. DreamerV3 combina percezione ricca e formazione immaginativa, incorporando tre reti neurali per la predizione di risultati futuri, la valutazione del valore di diverse situazioni e l’apprendimento su come navigare verso situazioni di valore.

tratto dalla mia newsletter : Metà nerd e metà..verso